Ein neues Zeitalter für Wortausrichtung in der maschinellen Übersetzung

Wir haben hier bei Lilt ein Team außerordentlich intelligenter und talentierter Personen, die hart daran arbeiten, die schwierigsten Herausforderungen der Übersetzungs- und Lokalisierungsbranche zu überwinden. Wir forschen ständig an neuen Möglichkeiten, um Lokalisierungs-Führungskräften wie Übersetzern gleichermaßen das Leben leichter zu machen.

Deshalb freuen wir uns, dass die Lilt-Mitarbeiter Thomas Zenkel, Joern Wuebker und John DeNero ein Dokument mit dem Titel „End-to-End Neural Word Alignment Outperforms GIZA++“ verfasst haben, in dem sie ihr rein neuronales Wortausrichtungssystem beschreiben, das eine relative Verbesserung der Ausrichtungsfehlerquote um 13,8 % bietet. Hier finden Sie eine kurze Zusammenfassung des Dokuments und warum es für die MT-Community so wichtig ist.

Die Verwendung von KI zur Übersetzung von Text aus einer Quellsprache in eine Zielsprache kann angesichts der vielen erforderlichen Kontextinformationen sehr schwierig sein. Während maschinelle Übersetzung die Muster modelliert, um zwischen Ausgangs- und Zielsätzen zu übersetzen, modelliert die Wortausrichtung die Beziehung zwischen den Wörtern des Quellsatzes mit einem Zielsatz. In diesem Aufsatz vergleichen wir unser neues, rein neuronales Wortausrichtungssystem mit dem aktuellen Branchenstandard-Statistiksystem GIZA++.

Bei der Übersetzung von digitalen Inhalten müssen Übersetzer mehr übertragen als nur den Text auf der Seite. Formatierung ist beispielsweise ein häufig angewendeter und wichtiger Aspekt von Online-Inhalten und findet in der Regel mittels Tags statt, wie für Fettdruck und für Kursivbuchstaben. Bei der Arbeit müssen Übersetzer sicherstellen, dass diese Tags präzise platziert werden. Leider gilt: Ist die Wortausrichtung ungenau, ist das Platzieren der Formatierungs-Tags sehr schwierig.

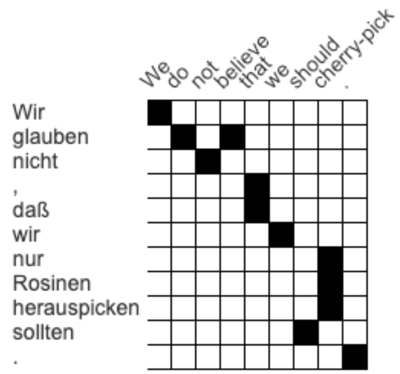

Diese Abbildung zeigt eine Attention Matrix, die darstellt, wie die Wörter eines Quellsatzes und dessen Übersetzung miteinander in Bezug stehen. Im Beispiel oben entspricht das deutsche wir dem englischen Wort we, während nicht mit not übereinstimmt. Diese Matrix wurde von einem menschlichen Übersetzer zusammengestellt, für die maschinelle Übersetzung kann diese Aufgabe aber ohne kommentierte Trainingdaten viel schwieriger sein.

Ein Beispiel: Verlangt der Inhalt, dass der oben angegebene Satz auf Englisch „We do not believe“ in Fettdruck erscheint, die Wortausrichtung aber nicht richtig ist, wird der Output auf Deutsch formatierte Tags enthalten, die wahrscheinlich an der falschen Position stehen. Das bedeutet, dass der falsche Text in Fettdruck angezeigt wird und der Übersetzer die Tags manuell ändern muss.

Derzeit ist das meistverwendete moderne Wortausrichtungssystem GIZA++. Es ist seit 2000 der Marktführer. Diese Wortausrichtungssysteme konzentrieren sich auf die Ausrichtungsfehlerquote (Alignment Error Rate oder AER), die die Ausrichtungsverknüpfungen eines automatischen Systems mit denen eines menschlichen Kommentators vergleicht.

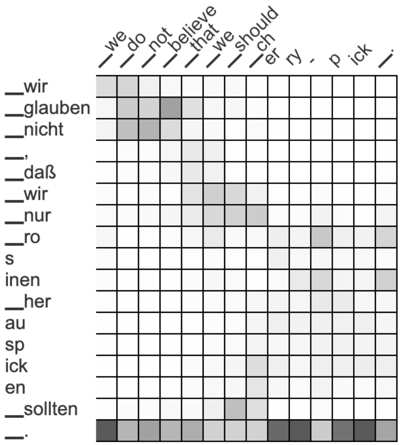

Das Lilt-Team verwendete einen Deutsch>Englisch-Datensatz, um seinen Ansatz zu kommentieren. Mit diesen Daten wies GIZA++ eine AER von 18,9 % auf. Um zu sehen, wie sie diesen Wert verbessern könnten, verwendeten Zenkel und sein Team das am häufigsten verwendete maschinelle Übersetzungssystem (einen Transformator) und visualisierten seine Attention-Aktivierungen. Die darauf basierende Extraktion von Ausrichtungen ergibt eine hohe AER von 66,5 %. Anstatt jedoch nur Schwarz-Weiß-Ausrichtungen zu zeigen, verwendet die Matrix oben jetzt Graustufen. Schwärzer bedeutet mehr Korrespondenz zwischen Wörtern, weißer bedeutet weniger.

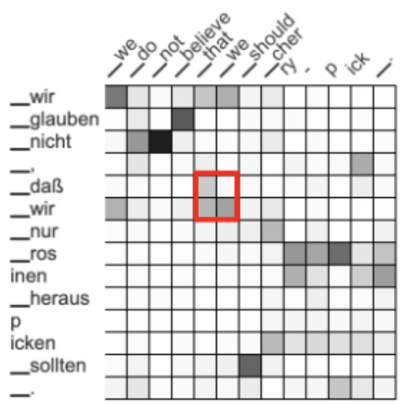

Durch Hinzufügen neuer Schritte mit Fokus auf Wortausrichtungsqualität statt der Übersetzungsqualität konnten sie die AER auf 34,5 % reduzieren. Dann erstellten sie Systeme, die Beziehungen zwischen benachbarten Wörtern belohnen. So entsprechen sich beispielsweise die benachbarten Wörter dass wir und that we. Es entstand ein Graumuster und das Team wollte die Aufmerksamkeit auf den oben hervorgehobenen Bereich erhöhen.

Das Ergebnis? Eine stärker konzentrierte Attention Matrix, die präziser die Beziehungen zwischen Wörtern vorhersagt. Durch diesen Schritt konnte die AER auf 27,8 % reduziert werden, was näher an dem Wert von GIZA++ liegt.

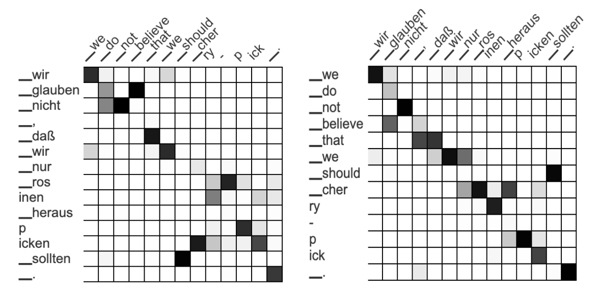

Die vielleicht größte Änderung erfolgte aber, als das Team begann, über die Übersetzung vom Deutschen ins Englische hinaus zu denken. Wenn Sie das Deutsch-ins-Englische-Modell (Vorwärtsmodell) mit dem Englisch-ins-Deutsche-Modell (Rückwärtsmodell) vergleichen, sollten die Ausrichtungen sehr ähnlich oder gar identisch sein.

Wenn das System gezwungen wird, die gleiche Wortausrichtung (oder Aufmerksamkeitsmatrix) für sowohl das Vorwärts- als auch das Rückwärtsmodell zu verwenden, kann es die Beziehungen zwischen Wörtern besser verstehen und vorhersagen. Bemerkenswerterweise fiel die AER dadurch auf 17,9 % und lag damit unter dem beeindruckenden GIZA++ Wert von 18,9 %. Mit einer weiteren Optimierung konnte das Team die Ausrichtungsfehlerquote auf 16,3 % verbessern, was zeigt, wie erfolgreich die Wortausrichtungen waren.

Letztendlich haben die Beiträge des Teams zu Ansätzen für die Wortausrichtung selbst das am weitesten verbreitete, modernste verfügbare System übertroffen. In Tests in anderen Sprachen (Englisch-Französisch und Rumänisch-Französisch) wurde bestätigt, dass dieser Ansatz bessere Leistungen bietet als statistische Ausrichtungssysteme der Konkurrenz, was zu einer niedrigeren AER als bei früheren Modellen führt. Verbesserte Wortausrichtungen erhöhen die Qualität für die automatische Übertragung von Formatierungsinformationen in die Übersetzung.

Wir sind äußerst stolz auf die erstaunliche Arbeit, die Zenkel, Wuebker und DeNero geleistet haben, und freuen uns darauf, zu sehen, was die Experten dieses Lilt-Teams demnächst in Angriff nehmen werden.