Une nouvelle ère pour l'alignement des mots dans la traduction automatique

Ici, chez Lilt, nous avons une équipe de personnes exceptionnellement intelligentes et talentueuses qui travaillent dur pour résoudre les défis les plus ardus de l'industrie de la traduction et de la localisation. Nous recherchons toujours de nouvelles façons d'améliorer la vie quotidienne des responsables de la localisation et des traducteurs.

C'est pour cela que nous sommes ravis de vous annoncer que Thomas Zenkel, Joern Wuebker et John DeNero de Lilt ont publié un article intitulé « L'alignement neuronal des mots de bout en bout surpasse GIZA++ », dans lequel ils décrivent leur système d'alignement de mots purement neuronal, ce qui permet de réduire le taux d'erreur d'alignement de 13,8 %. Voici un résumé rapide de l'article et des raisons pour lesquelles il est si important pour la majorité de la communauté de la traduction automatique.

Utiliser l'IA pour traduire le texte d'une langue source à une langue cible peut être une tâche extrêmement difficile, car toutes les informations contextuelles sont nécessaires. Bien que la traduction automatique modélise les schémas de traduction entre les phrases source et cible, l'alignement des mots modélise la relation entre les mots de la phrase source avec une phrase cible. Dans cet article, nous comparons notre nouveau système d'alignement de mots purement neuronal au système statistique standard actuel de l'industrie GIZA++.

Lorsque vous traduisez votre contenu numérique, les linguistes doivent traduire bien plus que le seul texte de la page. Par exemple, le formatage, un aspect important et communément utilisé du contenu en ligne, est généralement géré par des balises, tels que <b>les caractères en gras et <i>les caractères en italique. Lorsque les linguistes travaillent, ils doivent veiller à ce que ces balises soient placées avec précision dans le cadre de la traduction. Malheureusement, si l'alignement des mots est inexact, il est difficile de placer les balises de mise en forme.

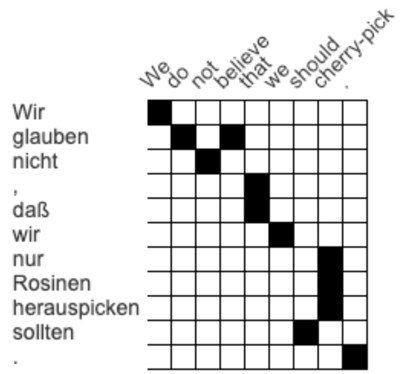

Cette image montre une matrice d'attention, elle démontre la manière dont les mots d'une phrase source et de sa traduction correspondent les uns aux autres. Dans l'exemple ci-dessus, wir en allemand correspond à we en anglais, alors que nicht correspond à not. Cette matrice a été réalisée par un traducteur humain, mais pour la traduction automatique, cette tâche peut être beaucoup plus difficile à faire sans aucune donnée d'entraînement annotée.

Par exemple, si le contenu nécessite que la phrase ci-dessus en anglais « We do not believe » soit en gras mais que l'alignement des mots est incorrect, le résultat en allemand comprendra des balises formatées qui seront probablement au mauvais endroit. Cela signifie que le texte incorrect sera en gras et que le linguiste devra changer manuellement les balises.

Le système statistique de pointe d'alignement des mots actuel s'appelle GIZA++ et est le numéro 1 depuis 2000. Ces systèmes d'alignement se concentrent sur le taux d'erreur d'alignement, communément appelé AER, qui compare les liens d'alignement d'un système automatique à ceux produits par un annotateur humain.

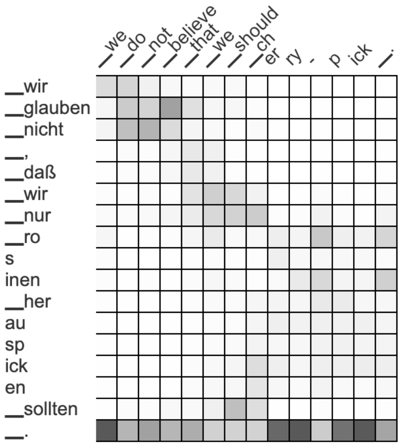

L'équipe de Lilt utilise un ensemble de données allemand > anglais pour annoter son approche. En utilisant ces données, GIZA++ avait un AER de 18,9 %. Pour voir comment ils pourraient améliorer ce score, Zenkel et l'équipe ont utilisé le système de traduction automatique le plus couramment utilisé (un transformateur) et ils ont visualisé ses activations d'attention. L'extraction des alignements basés sur ces résultats permet d'obtenir un AER élevé de 66,5 %. Cependant, au lieu d'afficher les alignements en noir et blanc, la matrice ci-dessus utilise désormais une échelle grise, plus de noir signifie plus de correspondance entre les mots, plus de blanc signifie moins de correspondance.

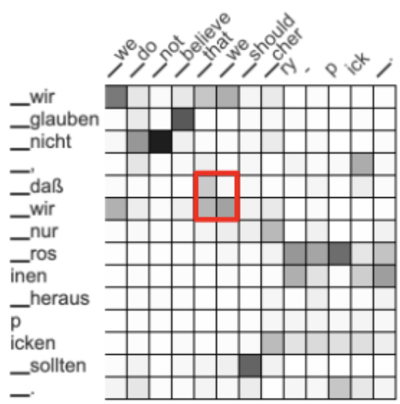

Cependant, en ajoutant de nouvelles étapes qui se concentrent sur la qualité de l'alignement des mots plutôt que la qualité de la traduction, ils ont pu réduire l'AER à 34,5 %. Ils ont ensuite développé des systèmes qui récompensent les relations entre les mots voisins. Par exemple, les mots voisins dass wir et that we correspondent les uns aux autres. Bien qu'un modèle gris ait émergé, l'équipe voulait augmenter l'attention dans la zone soulignée ci-dessus.

Le résultat ? Une matrice d'attention plus concentrée qui prédit plus précisément les relations entre les mots. Cette étape a réduit l'AER à 27,8 %, le rapprochant de celui de GIZA++.

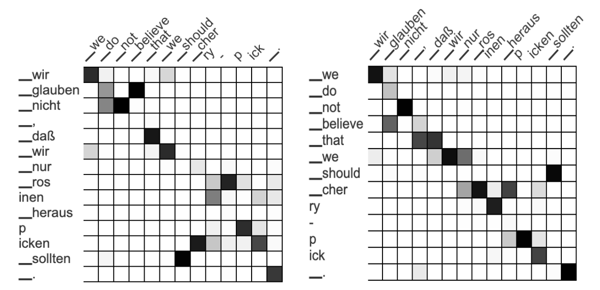

Le plus grand changement, cependant, est peut-être survenu lorsque l'équipe a commencé à réfléchir au-delà des simples traductions de l'allemand à l'anglais. Si vous comparez le modèle de l'allemand vers l'anglais (modèle avant) au modèle de l'anglais vers l'allemand (modèle arrière), les alignements devraient être très semblables, sinon identiques.

En forçant le système à utiliser le même alignement (ou matrice d'attention) à la fois pour les modèles avant et arrière, il peut mieux comprendre et prédire les relations entre les mots. Remarquablement, cela a fait chuté l'AER à 17,9 %, descendant sous l'impressionnant score de GIZA++ de 18,9 %. Avec un ajustement supplémentaire, l'équipe a pu réduire le taux d'erreur d'alignement à 16,3 %, démontrant à quel point l'alignement des mots était réussi.

En définitive, les contributions de l'équipe aux approches d'alignement des mots ont surpassé même le système de pointe disponible le plus largement adopté. Les tests dans d'autres langues (anglais-français et roumain-français) ont confirmé que cette approche dépasse les systèmes d'alignement statistique concurrentiels, ce qui a entraîné un AER inférieur aux modèles précédents. L'amélioration de l'alignement des mots améliore la qualité pour le transfert automatique des informations de formatage dans la traduction.

Nous sommes extrêmement fiers du travail incroyable que Zenkel, Wuebker et DeNero ont accompli. Nous sommes impatients de voir ce que les experts de l'équipe de Lilt seront en mesure de trouver par la suite.