Una nueva era para la alineación de palabras en la traducción automática

En Lilt, tenemos un equipo lleno de individuos excepcionalmente inteligentes y talentosos que trabajan arduamente para resolver los desafíos más difíciles de las industrias de traducción y localización. Siempre estamos investigando nuevas formas de mejorar las vidas cotidianas de los líderes de localización y de los traductores.

Por eso, nos complace compartir que Thomas Zenkel, Joern Wuebker y John DeNero de Lilt han publicado un artículo llamado «La alineación de palabras neuronal e integral supera a GIZA++». En él, describen su sistema de alineación de palabras puramente neuronal que proporciona una mejora relativa del 13,8 % en la tasa de error de alineación. A continuación, hay un resumen breve del artículo y por qué es importante para la comunidad de la traducción automática.

Usar la IA para traducir un texto de un idioma de origen a un idioma de destino puede ser una tarea extremadamente difícil debido a la información contextual requerida. Mientras que la traducción automática modela los patrones para traducir entre las oraciones de origen y las de destino, la alineación de palabras modela la relación entre las palabras de la oración de origen con las de la oración de destino. En este artículo, comparamos nuestro nuevo sistema de alineación de palabras puramente neuronal con el sistema estadístico estándar de la industria actual, GIZA++.

Cuando se traduce contenido digital, los lingüistas tienen que traducir más que el texto que se ve en las páginas. El formato, por ejemplo, es un aspecto frecuente e importante del contenido en línea que se gestiona con etiquetas, por ejemplo para marcar letras en negrita o en cursiva. Cuando los lingüistas trabajan, deben asegurarse de que estas etiquetas se colocan con precisión como parte de la traducción. Lamentablemente, si la alineación de palabras no es correcta, ubicar las etiquetas de formato se hace muy difícil.

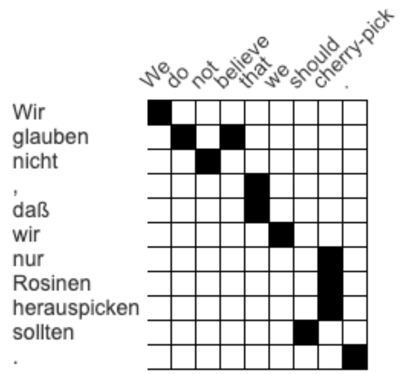

La imagen muestra una matriz de atención: se visualiza cómo las palabras de una oración de origen y su traducción se corresponden entre sí. En el ejemplo anterior, wir en alemán coincide con el we en inglés, mientras que nicht coincide con el not. Esta matriz fue creada por un traductor humano, pero para la traducción automática puede ser una tarea mucho más difícil de hacer sin datos de entrenamiento comentados.

Por ejemplo, si el contenido requiere que la oración anterior en inglés «We do not believe» (No creemos) esté en negrita y la alineación de palabras es incorrecta, el resultado en alemán incluirá etiquetas de formato que probablemente estén en la posición equivocada. Esto significa que quedará en negrita el texto incorrecto y que el lingüista tendrá que cambiar la ubicación de las etiquetas manualmente.

El sistema de alineación de palabras estadístico de última generación se llama GIZA+++ y ha liderado en el sector desde 2000. Este sistema se centra en el índice de error de alineación, conocido comúnmente como AER por sus siglas en inglés, que compara los enlaces de alineación de un sistema automático con los que se producen a partir de un comentarista humano.

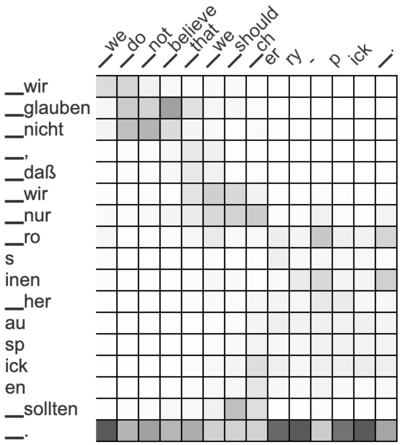

El equipo de Lilt usó un conjunto de datos del alemán al inglés para comentar su enfoque. Con estos datos, GIZA++ tuvo un AER de 18,9 %. Para ver cómo podían mejorar esa puntuación, Zenkel y su equipo utilizaron el sistema de traducción automática más usado (un transformador) y visualizaron sus activaciones de atención. La alineación extraída de ese sistema arrojaba un AER más alto, de 66,5 %. Sin embargo, en lugar de mostrar solo alineaciones en blanco y negro, la matriz de arriba utilizaba una escala de grises, en la que una mayor cantidad de negro indica más correspondencia entre palabras y una mayor cantidad de blanco significa menos correspondencia.

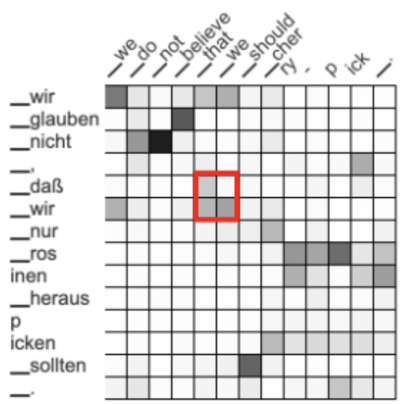

No obstante, al agregar nuevos pasos que se centraban en la calidad de la alineación de palabras en lugar de en la calidad de la traducción, pudieron reducir el AER a un 34,5 %. Luego, construyeron sistemas que recompensan las relaciones entre palabras vecinas. Por ejemplo, las palabras vecinas dass wir y that we se corresponden entre sí. Aunque surgió un patrón gris, el equipo quería aumentar la atención en el área destacada anteriormente.

¿Cuál fue el resultado? Una matriz de atención más concentrada, que predice con precisión las relaciones entre las palabras. Ese paso redujo el AER a un 27,8 %, más cercano al del índice de GIZA++.

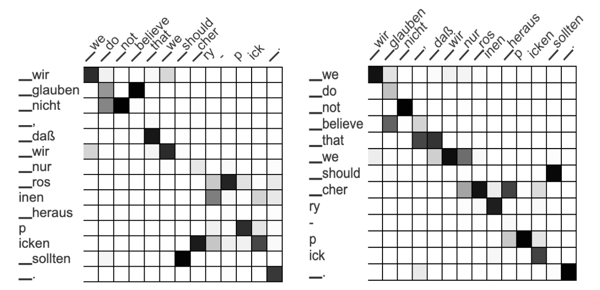

Quizás el cambio más importante llegó cuando el equipo comenzó a pensar más allá de traducir solo del alemán al inglés. Si comparas el modelo de alemán a inglés (modelo hacia adelante) con el modelo de inglés a alemán (modelo hacia atrás), las alineaciones deben ser muy similares, cuando no idénticas.

Al forzar al sistema a usar la misma alineación de palabras (o matriz de atención) tanto para el modelo hacia adelante como para el modelo hacia atrás, puede comprender mejor y predecir las relaciones entre las palabras. Notablemente, esto hizo que descendiera el AER a 17,9 %, con lo que quedó por debajo del impresionante puntaje de GIZA++ de 18,9 %. Con una modificación más, el equipo pudo mejorar el índice de error de alineación hasta un 16,3 %, con lo que se pudo demostrar cuán exitosas fueron las alineaciones de palabras.

Básicamente, las contribuciones del equipo a los enfoques de alineación de palabras han superado hasta los sistemas disponibles más vanguardistas y ampliamente adoptados. Las pruebas en otros idiomas (inglés-francés y rumano-francés) han confirmado que este enfoque supera los sistemas de alineación estadística competitivos, ya que genera un AER menor que sus modelos previos. Las alineaciones de palabras mejoradas aumentan la calidad de la transferencia automática de información con formato a la traducción.

Estamos muy orgullosos del increíble trabajo que han logrado Zenkel, Wuebker y DeNero y nos complace ver lo que podrán lograr en el futuro los expertos del equipo de Lilt.